설치pip install beautifulsoup4conda install beautifulsoup4 사용html 개체로부터 Soup 만들기from bs4 import BeautifulSoupsoup = BeautifulSoup(html_doc)print(soup.prettify()) # 객체의 내포된 데이터 구조를 보여줌 xml 개체로부터 Soup 만들기lxml이 설치되어 있어야 한다.설치는 위에서 BeautifulSoup를 설치하는 것처럼 라이브러리 이름만 변경하면 된다.from bs4 import BeautifulSoupsoup = BeautifulSoup(xml_doc, 'xml') 메서드find, find_allfind()는 해당 이름의 첫 번째 태그만 반환한다.find_all()은 해당 태그를..

ChromeOptions브라우저 창을 숨기는 설정브라우저를 GUI 없이 실행options = webdriver.ChromeOptions()options.add_argument("--headless")# options.add_argument("--headless=new") 사람처럼 보이게브라우저가 서버와 통신할 때 자신을 나타내기 위해 User-Agent를 보낸다.이를 통해 브라우저 유형과 운영 체제를 식별 가능하다.봇 탐지하는 것을 피하는 방법이다.options.add_argument("user-agent=Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/91.0.4472.124 Safari/537..

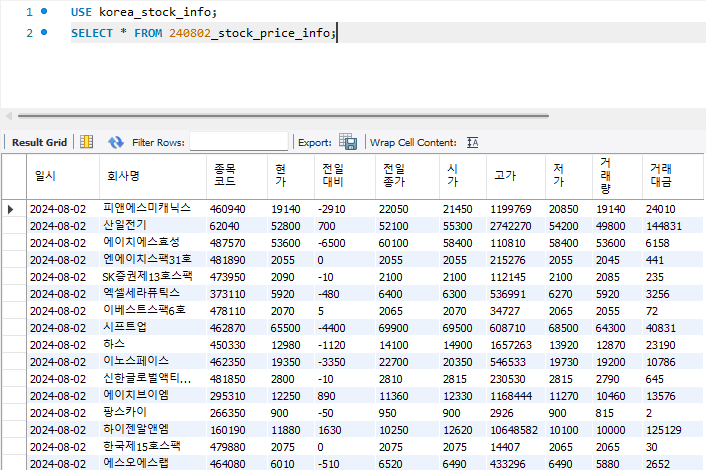

진행 단계3단계로 데이터를 저장할 수 있습니다.데이터 수집 : Selenium데이터 정제 및 모델링 : Beautiful Soup데이터 저장 : MySQL, Pandas데이터 수집Selenium을 사용하여 html 데이터를 가져오려고 합니다.예시에서는 네이버 증권을 접속하도록 하겠습니다. Selenium 패키지 사용from selenium import webdriverfrom selenium.webdriver.chrome.service import Service as ChromeServicefrom webdriver_manager.chrome import ChromeDriverManagerfrom selenium.webdriver.common.by import Byfrom selenium.webdrive..